FOTOGRAFIA PLANETARIA: ISTRUZIONI parte 1

INTRODUZIONE

Quando si comincia l’avventura della fotografia planetaria il neofita è roso da mille dubbi.

Scelta la strumentazione con cui operare (sulla quale questo breve articolo non vuole porre limiti, anche perché talvolta questi sono imposti dal budget o dalle condizioni in cui ci si trova ad operare, spazio, seeing, e via discorrendo) che comprende sia il telescopio che il sensore per le riprese vere e proprie, il passo successivo è quello di capire cosa e come fare.

Io stesso, neofita, mi sono scontrato con alcuni logici dubbi dovuti principalmente al settaggio della strumentazione e, in particolar modo, della camera di ripresa.

Il mio caso specifico è limitato all’uso di una ASI 120MM con sensore CMOS monocromatico ma ritengo che, quanto andremo a vedere, possa essere valido anche per sensori CCD classici o per le webcam più economiche.

IL SEEING

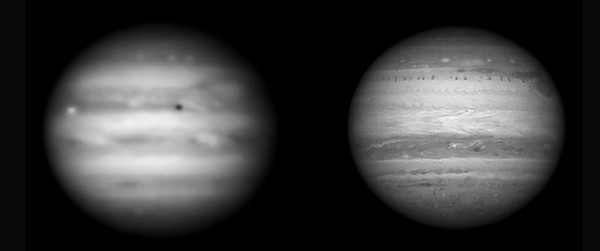

Su questo non mi dilungherò oltre a segnalarvi una comparazione interessante eseguita dal prolifico e sempre bravissimo JOSEPH BRIMACOMBE sul pianeta Giove. Riporto per intero il suo contributo:

Both images taken with a Mewlon 250 and Skynyx 2-0 high speed video camera at F/44 with Jupiter directly overhead and using a clear filter.

FOCALE DA USARE

Il valore della focale è importante perché permette, se ben valutato, di ottenere il massimo dal nostro sistema telescopio/camera di ripresa.

Quando ammiriamo le immagini prodotte dai bravi imager italiani o stranieri dobbiamo preoccuparci di capire con quali compromessi hanno lavorato. Nel farlo scopriamo che, seeing permettendo, ci sono dei limiti all’interno dei quali i fotografi esperti restano per evitare di perdere informazione preziosa o di ridurre eccessivamente velocità di acquisizione.

Ho così studiato, attingendo dai forum vari (anche internazionali), dai pochi tutorial disponibili (sembra che gli imager di alto livello siano incredibilmente gelosi dei propri “segreti”) e anche da un po‘ di logica dettata dalla fisica e ottica a me conosciuta.

Sono così giunto a determinare una formula di massima che tenga in considerazione due aspetti fondamentali e inopinabili del problema: il diametro del telescopio usato e la dimensione dei pixel del sensore impiegato.

Quanto riporterò è, e così deve essere inteso, una “semplificazione” in quanto la formuletta spiccia si riferisce a una particolare lunghezza d’onda, nel nostro caso quella centrata sui 550 nm.

Al variare della lunghezza d’onda di ripresa varia infatti anche la risposta di sensibilità del sensore usato. Ci si accorge facilmente di quanto questa sia discriminante quando si provano ad eseguire test, mantenendo costante strumentazione e focale di ripresa, modificando la regione di spettro fotografata. Un filtro IR-PASS ad esempio, che permette solamente il passaggio della parte rossa della luce visibile, modifica enormemente le prestazioni del nostro sensore.

Restiamo quindi per il momento “ancorati” ai nostri 550 nm, quindi alla luce giallo/verde a cui nostro Signore ci ha resi particolarmente sensibili, e accontentiamoci della seguente espressione:

F/D=4,47*k*L

dove:

F = lunghezza focale finale di ripresa

D = diametro dello strumento espresso in millimetri

k = coefficiente di correzione dovuto alla regione spettrale di ripresa (nel caso dei 550 nm. da considerarsi pari ad 1)

L = dimensione dei pixel della nostra CMOS o CCD espressa in micron

Questa formula, sia chiaro prima di creare fraintendimenti, prevede che il sensore sia sufficientemente sensibile da mostrare variazioni di resa tra un pixel e quello adiacente.

Nel caso ciò non avvenisse (prendiamo ad esempio un sensore a colori dotato di matrice di Bayer), il valore “L” dovrà tenere in considerazione questo handicap. Per aiutarci possiamo semplificare il discorso accettando che, solitamente, un sensore dotato di microlenti Bayer, ha una capacità di risoluzione che è inferiore e le differenze di sensibilità percepibili richiedono un paio di pixel per essere avvertite. Per essere meno aleatori questa sensibilità (lavorando sul quadrato di 4 pixel) corrisponde a circa 100/141.

Se quindi stiamo lavorando con una CMOS o CCD a colori ricordiamoci di usare, come valore “L”, quello del lato dei pixel moltiplicato per circa 1,41.

Ora, poiché gli esempi pratici valgono sempre più di tante parole, immaginiamo di voler trarre il massimo da uno strumento da 25 cm. accoppiato a una camera CMOS monocromatica (visto che vanno per la maggiore) e scegliamo quella che ho io (per comodità): una ASI 120MM con pixel quadrati da 3,75 micron.

Otteniamo questo:

F = 4,47*1*3,75*250

con F che, di conseguenza, vale circa 4190 millimetri.

Se quindi abbiamo un bello Schmidt cassegrain da 25 cm. a f10 sappiamo che una barlow 2x è più che sufficiente per ottenere, in monocromatica e con la ASI 120MM) la miglior risoluzione possibile.

Si può però anche considerare un’altro approccio, che personalmente ritengo più corretto e veritiero.

Il “nostro” 25 cm. ha una risoluzione teorica pari a 0,48”.

Risulta, a questo punto, corretto ricordare che nessun sensore ci mostrerà differenze sostanziali tra un pixel e l’altro e che quindi, per “vedere” tutta la risoluzione possibile, il telescopio dovrà porre la sua risoluzione teorica a disposizione di almeno 2 pixel.

Nel nostro caso avremo:

40”/0,48 = 83,33 * 2 (pixel) = 166 pixel. (il primo valore è la dimensione media di Giove espressa in arcosecondi).

Questo ci dice che il nostro GIOVE deve essere grande ALMENO 166 pixel per permetterci di lavorare (seeing permettendo) con la massima risoluzione offerta dal nostro telescopio.

Ora bisogna però anche accettare che il seeing medio di cui sovente disponiamo è modesto e quindi pensare che bastino 2 pixel per ottenere il massimo risulta essere una utopia.

Si sceglie quindi di alzare il valore di minimo di 2 pixel a 4, il che porta Giove a dover essere grande circa 330 pixel. La focale che ne risulta diventa quindi frutto della situazione reale di ripresa.

Quando usiamo le nostre telecamere CMOS o i nostri sensori CCD e li tariamo su risoluzioni di 640x480 (che permettono una velocità di FPS decente) sappiamo che Giove dovrebbe, in teoria, occupare metà del lato lungo (dimensione permessa solo da focali superiori ai 4,20 metri indicati dalla formula F/D=4,47*k*L).

Accettiamo quindi l’inesistenza di una formula universale e la necessità, da bravi intenditori, che i parametri corretti debbano essere scelti di volta in volta a seconda delle condizioni di ripresa.

DURATA DEI FILMATI

Annoso problema che dipende da tanti fattori tra cui, in primis, il pianeta da ritrarre e la sua velocità di rotazione. Le limitazioni maggiori si incontrano ovviamente su Giove, e di questo parleremo, più che altro dovute alla veloce rotazione del suo disco (che, per inciso, vede le nubi equatoriali muoversi a velocità differente da quelle polari). Anche Saturno ha fretta, ma il suo diametro è molto più limitato e i particolari superficiali sono così poco contrastati da renderlo meno “sensibile” al problema della rotazione.

Indipendentemente dal fatto che si lavori in monocromia o in tricromia o policromia (magari usando anche riprese ottenute con filtri nel vicino infrarosso) la regola “base” impone che la somma totale del tempo di ripresa non debba superare la soglia oltre alla quale la nostra camera di ripresa sovrapporrà sugli stessi pixel immagini di aree contigue. Questo, ovviamente, dipende dalla focale con cui lavoriamo ma anche dal potere risolutore dell’ottica utilizzata.

In “giro” si legge che, su Giove, è opportuno non spingersi oltre gli 100 secondi di ripresa. Ma è proprio vero?

Il diametro apparente di Giove varia, a seconda della posizione rispetto alla Terra, tra i 30” e i 49” circa. Usare quindi un valore di riferimento di circa 40” appare corretto (ma attenzione: NON lo è, quindi valutate bene, per ottenere il massimo, la sua reale dimensione apparente all’atto di fotografarlo!) e può essere impiegato per capire di cosa parliamo.

Diciamo che Giove abbia un diametro standard di 40” e, di conseguenza, una circonferenza pari a circa 125”.

Sappiamo anche che Giove ruota (valore medio) in circa 10 ore, quindi in 600 minuti (accettiamo questo valore che è “semplice”).

Da questi due fondamentali dati si evince che il nostro amico gassoso ruota di 125/600 = 0,21” al minuto quando ha un diametro apparente di 40 arcosecondi.

Ora scriviamo una formula semplice semplice che ci aiuti a capire cosa fare:

T = RisT/Vr

dove:

T = tempo espresso in minuti

Ris = risoluzione teorica del nostro strumento

Vr = velocità di rotazione (pari a 0,21” al minuto per un diametro di 40”)

Siccome siamo sempre affezionati al nostro Schmidt Cassegrain da 25 cm. proviamo a calcolare “quanto tempo abbiamo” usando questo strumento:

Il potere risolutore di un 25 cm. è (sempre in luce giallo/verde e con formula “alla carlona”) è pari a 120/250, quindi 0,48” (secondi d’arco). In realtà il seeing standard difficilmente permette simili performances ma immaginiamo di essere particolarmente fortunati e di lavorare in luoghi “magici”. Applichiamo la formula e scopriamo:

T = 0,48/0,21 = 2,58 minuti (che è il tempo massimo oltre il quale al “meridiano centrale” noteremo un “mosso”).

Molti, meno pessimisti, indicano una formula più universale che è questa:

Imax = 180(R/(D*Vr))

dove:

Imax = Intervallo di tempo max

(espresso in minuti)

D = Diametro del pianeta in secondi d’arco

R = Risoluzione ottimale dello strumento in secondi d’arco

Vr = Velocità di rotazione angolare del pianeta in gradi/minuto

Nel caso del nostro 25 cm. si otterrebbe: Imax = 180 * ( 0,48 / ( 40 * 0,6) ) = 3,6 minuti

Io sono poco propenso a considerarla “corretta” tout court ma consiglio di provare a fare esperimenti e decidere cosa usare e come farlo...

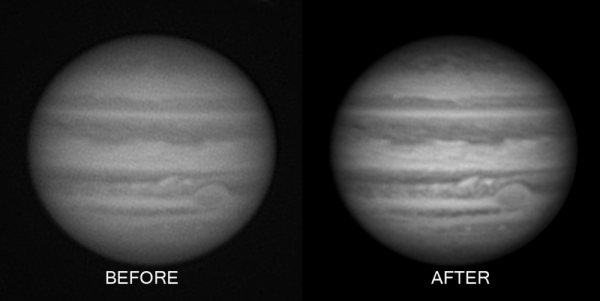

Immagine di DANIEL ROBB che mostra la differenza tra una ripresa di Giove derotata (a destra) e non. Ben marcata la perdita di definizione dovuta alla visibile rotazione del pianeta durante la ripresa.

QUANTITA' DEI DATI

Anche questo è un aspetto importante.

Si dice “quanti più frame possibili!”, ed è vero, almeno per 2 motivi.

Il primo è che più frame abbiamo a disposizione e maggiore sarà la possibilità che ce ne siano tanti di buon livello da usare per lo stacking.

Il secondo motivo è che, quando andremo ad agire sui wavelet in fase di elaborazione primaria, maggiore sarà l’informazione a disposizione e minori saranno gli artefatti che si creeranno sull’immagine.

I problema è che, in base a quanto scritto e detto ai capitoli precedenti, non possiamo avere “tutti i frame del mondo” poiché a limitarci ci pensano il tempo di acquisizione e la velocità del sensore usato (che è anche influenzata dalla focale impiegata e quindi dalla dimensione del sensore che usiamo per ottenerla: 640x480 o meno - maggiore velocità - o più - minore velocità).

Noi abbiamo sempre il nostro 25 cm. e stiamo lavorando con una ASI 120MM e un formato di acquisizione di 648x480 (altrimenti non avremmo abbastanza campo per Giove e per le micro-correzioni di inseguimento).

Quindi abbiamo, in sostanza, 2,5 minuti di tempo a 640x480 con un frame rate che, volendo tenere bassi sia il GAIN che il GAMMA (così riduciamo il rumore e non roviniamo le nuvole scure del pianeta), non sarà superiore ai 25 FPS.

Se facciamo due conti scopriamo che il nostro filmato finale avrà un numero di frame pari a circa 150 secondi * 25 fps: 3750 frame quindi (mica male, tutto sommato).

Ma non siamo alle Barbados e nemmeno sulla Luna e, dopo aver fatto analizzare il filmato da un programma specifico (Autostakkert o quello che vi è più simpatico) scopriamo immancabilmente che i frame di qualità superiore al 60% sono solo il 30/35% del totale (quindi poco più di 1200).

Come direbbe GioleDix: “APRITI CIELO”!

Ognuno dice la sua: per alcuni sono molti, per altri sono pochi, alcuni “chiedono alla moglie”, altri scrutano l’immaginetta di Padre Pio, altri ancora tacciono.

Io posso solo dire che, dal mio punto di vista, non sono tanti per niente.

1200 frame permettono di elevare in modo modesto i wavelet prima che il rumore si insinui subdolo e renda le nostre immagini delle “forzate caricature” di Giove, ma questo è il mio personalissimo parere che, magari, il tempo cambierà.

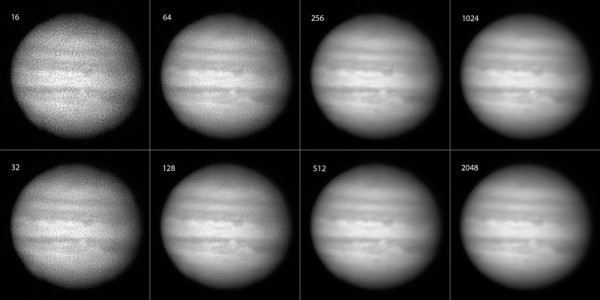

A questo proposito ci viene in aiuto un lavoro interessante fatto da un affiliato al sito www.flicr.com e rintracciabile come s58y. Non sono riuscito a contattarlo ma spero che, citandolo, mi permetta di usare questa sua comparazione. Il "nostro" ha eseguito una serie di stacking su una ripresa di Giove usando un numero variabile di frames.

Per correttezza riporto interamente il suo contributo:

First light Jupiter test images (no filters) -- 400% crop

Image Scale = 0.29 arc-second/pixel

Date: 2012/09/02 - 02:08 AM

Exposure: 60fps at 1/120 sec -- 16/32/64/128/256/512/1024/2048 frames selected out of 3596 total (1 minute AVI file)

Telescope: Celestron EdgeHD 800 (8-inch) with 2x powermate = 4000mm at f/20 (approx)

Camera : DMK21AU618

Filters: none (filter wheel in-place, but empty)

Mount: Astro-Physics AP900 -- rough polar alignment (no drift alignment)

Processing:

Jupiter was just rising above the trees. Five one minute videos were shot at 60fps, and this is the last and best one. Exposures were 1/60, 1/120, and 1/250 sec per frame, but 1/120 sec seemed to work out best. Seeing was horrible -- it looked like Jupiter was printed on a flag waving in the wind. In-focus collimation was not possible, due to bad seeing, so only out-of-focus collimation was done. Seeing got somewhat better as Jupiter rose farther above the trees, but clouds rolled in after an hour or so. One final short video was shot through a hole in the clouds as Jupiter rose much higher, and it looks promising, but it is not shown here.

The AVI file from video camera was processed by AutoStakkert 2, with mostly default settings (AP size = 25, 61 alignment points, automatically placed, Noise robust = 4, Planet COG, Dynamic background, Gradient quality estimator, no drizzle). The number of stacked frames from the video is 16, 32, 64, 128, 256, 512, 1024, or 2048 out of 3596 total, and is marked above each output Jupiter image. Each 640x480 output TIFF was cropped to 160x160, rotated clockwise 90 degrees, and enlarged 4x with "nearest neighbor" processing,to show individual pixels. Photoshop levels was used on each output TIFF, and all 8 were combined into one big file (with labels) using Photoshop. JPEG conversion was done with quality = 12 in Photoshop.

E’ interessante notare come sembrino non esserci differenze sostanziali tra la versione a 1024 frame e quella 2048. In effetti, se si ingrandisce l’immagine e si cerca di essere obiettivi, si notano alcuni particolari meglio risolti nella versione con numero inferiore di fotogrammi ma anche il contrario.

Questo, unitamente al fatto che, in totale, il nostro amico ha filmato 3596 frame su cui ha poi scelto i migliori 1024 e 2048, mi fa pensare che i 2048 frame scelti abbiano una qualità media inferiore a quella dei primi 1024 e che, quindi, non ci fossero i presupposti di “segnale” per usare un numero così alto di frame in fase di stacking e allineamento.

Concludo quindi questa prima parte augurando a tutti noi pazienza, buon seeing, e strumenti di qualità!